Ce qui fut longtemps présenté comme une innovation dématérialisée s’ancre désormais dans le réel. La montée en puissance de l’IA se heurte aux limites physiques de notre monde. L’IA met sous tension nos infrastructures autant que l’aménagement de nos territoires jusqu’à remettre en cause la seule logique de puissance de calcul, au profit d’une exigence d’efficience énergétique.

Trois chiffres 10-100 et 1000, dessinent les contours d’un basculement majeur. D’ici 2030, les data centers pourraient représenter jusqu’à dix % de la consommation électrique des États-Unis. OpenAI prévoit de multiplier par cent sa capacité énergétique d’ici 2033. Et la demande globale liée à l’IA, au cloud et aux usages intensifs pourrait générer mille térawattheures supplémentaires chaque année, soit l’équivalent de la consommation du Japon. Ces ordres de grandeur marquent un véritable déplacement du centre de gravité du numérique. L’intelligence artificielle ne se définit plus seulement par sa puissance de calcul, mais par son inscription dans les équilibres énergétiques mondiaux.

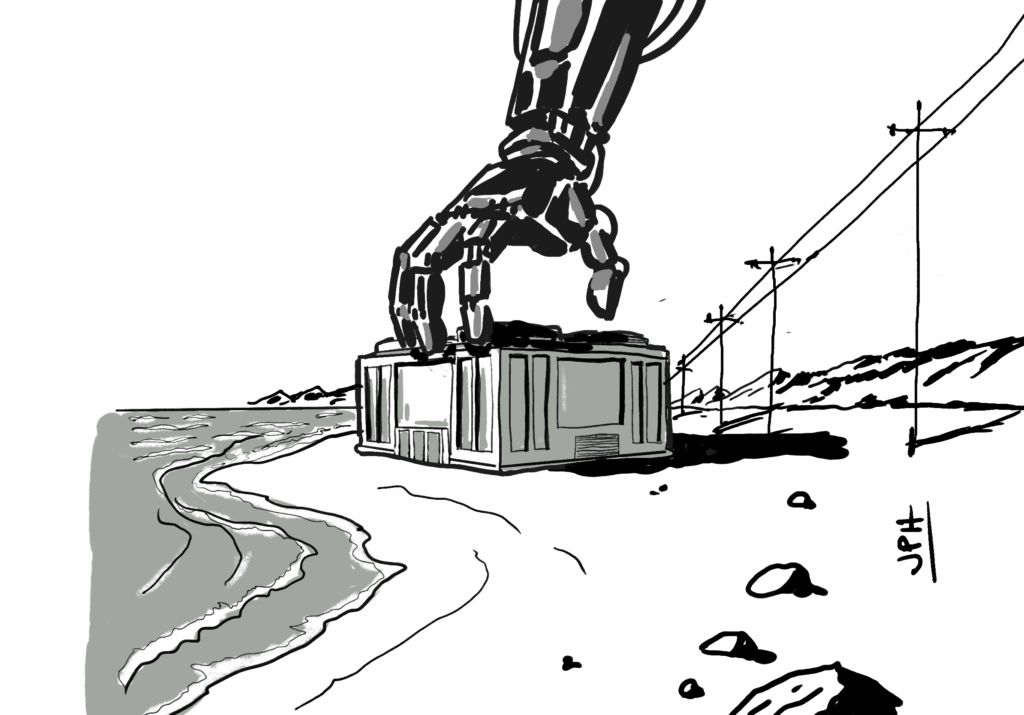

On dit souvent que l’intelligence artificielle repose sur les données. C’est exact, mais cela ne rend pas compte de sa réalité physique. Ce qui fait fonctionner ces modèles, c’est l’énergie. Une alimentation constante est nécessaire pour les entraîner, et les exécuter. Certains centres de calcul consomment autant qu’une ville moyenne. Ils deviennent des infrastructures stratégiques à part entière. Autrefois, on construisait des routes ou des voies ferrées. Aujourd’hui, les data centers structurent le territoire. Leur implantation dépend des capacités de raccordement et de la stabilité du réseau électrique. Le dimensionnement des lignes, la résistance des transformateurs et les points de délestage local conditionnent l’expansion du calcul. Dans plusieurs pays, ces installations entrent dans la planification territoriale et sont classées comme prioritaires. Le réseau actuel atteint ses limites face à cette nouvelle demande.

Cette bascule se lit clairement dans la façon dont les acteurs se repositionnent. Les opérateurs de réseau sont désormais sollicités pour des projets d’une ampleur inédite, bien au-delà de leurs cadences habituelles. Les géants du numérique négocient directement avec les producteurs d’énergie : Microsoft a investi dans Helion, une entreprise spécialisée dans la fusion nucléaire ; Amazon s’est allié à Brookfield pour sécuriser des capacités en hydroélectricité ; Google collabore avec Ørsted sur des parcs éoliens de nouvelle génération. Le sujet n’est plus seulement de déployer des serveurs, mais d’en garantir l’alimentation sur dix ou vingt ans. L’emplacement d’un data center dépend à présent de la proximité d’une source d’électricité stable. Ces décisions sont à la fois logistiques et politiques. Ce que l’on appelle encore “cloud” repose sur une infrastructure finie : les réseaux ont une capacité, l’électricité a un coût, et la stabilité du mix énergétique devient un enjeu stratégique majeur. L’intelligence artificielle ne flotte pas dans l’air : elle s’ancre dans le réel.

L’avenir du computing se joue sans doute du côté de l’ordinateur quantique. Contrairement aux supercalculateurs classiques, il ne consomme que très peu d’énergie pour traiter l’information. Ses qubits, fondés sur les lois de la mécanique quantique, fonctionnent à des niveaux d’énergie infimes, capables d’effectuer en quelques secondes des opérations que les machines actuelles mettraient des années à résoudre. Le paradoxe, c’est que cette frugalité énergétique s’accompagne d’un coût colossal ailleurs : le refroidissement. Pour que ces qubits restent stables, il faut maintenir leur environnement à des températures proches du zéro absolu, autour de –273 °C. C’est cette cryogénie extrême, bien plus que le calcul lui-même, qui consomme massivement de l’électricité. Ce défi thermique pousse la recherche à innover dans la gestion du froid et la conception des infrastructures. En France, des acteurs comme Pasqal ou Alice & Bob travaillent sur des architectures capables de fonctionner à température plus élevée, tandis que d’autres explorent des voies plus “naturelles”, comme les data centers immergés ou alimentés par l’eau froide au large des côtes bretonnes. Ces initiatives traduisent une conviction : la performance future du numérique ne dépendra pas seulement de la puissance de calcul, mais aussi de notre capacité à maîtriser le froid.

Dans cette situation, plusieurs réponses émergent. L’une vise à réduire la redondance des calculs, à mutualiser les ressources, à revoir les paramètres d’entraînement des modèles. Non pas pour limiter l’ambition, mais pour ajuster la dépense énergétique à la valeur créée. Une autre approche cherche à rapprocher les centres de calcul des zones de production bas-carbone. Cela peut être de l’hydroélectricité en Norvège, du nucléaire en France, ou d’autres solutions locales permettant de stabiliser l’approvisionnement. Enfin, certains projets explorent la possibilité de l’IA à optimiser elle-même les réseaux électriques, en modélisant les flux, en régulant la demande, en pilotant les charges. Ces mouvements convergent vers une même idée : intégrer l’IA dans les logiques physiques plutôt que l’en abstraire.

C’est un changement de cycle. Jusqu’ici, les grandes avancées de l’IA ont été jugées à l’aune de la performance brute. La prochaine phase s’annonce différente. L’efficacité énergétique devient un critère en soi. Certains fonds d’investissement commencent à en tenir compte dans leurs allocations. Des entreprises testent des architectures capables d’ajuster leur consommation en fonction de la charge réseau. Plusieurs startups émergent avec une proposition claire : produire de l’intelligence avec moins d’énergie. Cette dynamique commence à structurer un nouveau champ. Après la ruée vers les données, voici celle vers la puissance propre. Ce n’est pas un effet de mode. Ce sont les premiers jalons d’une reconfiguration du capitalisme numérique autour de l’énergie bas-carbone.

La révolution de l’intelligence artificielle met en lumière une tension nouvelle entre technologie et énergie. Ces deux dynamiques, longtemps perçues comme indépendantes, avancent désormais de pair. Dans cette économie, l’énergie devient une ressource stratégique, au même niveau que les semi-conducteurs ou les données. Elle structure les chaînes de valeur et transforme les modèles économiques. Elle redéfinit aussi les rapports de force entre régions capables de produire une électricité stable, abordable et décarbonée, et celles qui en dépendent. Bientôt, un modèle d’IA performant ne sera plus seulement celui qui raisonne juste, mais celui qui le fait avec le moins d’énergie possible. La frontière entre la technologie et le climat s’efface progressivement. L’IA ne sauvera pas le climat, mais elle ne pourra pas se développer sans lui. L’innovation ne réside plus dans la puissance des modèles, mais dans leur capacité à s’inscrire dans un cadre énergétique soutenable. L’enjeu n’est plus de créer plus d’intelligence, mais de rendre cette intelligence compatible avec les limites de la planète.